Похоже, что GPT-5 и правда лучшая доступная на сегодня модель.

Если не понято, почему эта картинка — прочитайте статью Пеликаны на велосипедах.

Похоже, что GPT-5 и правда лучшая доступная на сегодня модель.

Если не понято, почему эта картинка — прочитайте статью Пеликаны на велосипедах.

Обсуждали с товарищем, как сложно теперь стало начать торговлю онлайн.

Сделать сайт оказалось самой понятной частью квеста.

Раньше (00-е):

– Зарегистрировал ИП, отстояв очередь в налоговой.

– Сходил в соседние здания в статистику и пенсионный и там тоже какие-то заявления сдал.

– Купил бумажную книгу учёта доходов и расходов.

– Сходил в банк, подписал кучу бумаги и передал образцы подписи.

– Подписал договор с эквайрингом.

– Бухгалтер — тётя Валя.

– Рекламу купил переводом на карту, её просто разместили.

– Принимаешь деньги.

Прошло 20 лет:

– Получил доступ к Госуслугам.

– Выпустил электронную подпись.

– Зарегистрировал ИП удалённо.

– Открыл счёт в банке удалённо.

– Завёл ЭДО.

– Подписал договор с эквайрингом.

– Подписал договор с ОФД и завёл онлайн-кассу.

– Сервис для бухгалтерии или аутсорс, в облачную 1С приходится ходить.

– Как, вы живёте без CRM? Так нельзя! Завёл CRM.

– Зарегистрировался в Честном знаке.

– Интегрировать всё это друг с другом.

– Льём рекламу? Зарегистрируйте каждый креатив, получите идентификатор, отчитайтесь.

Цифровизация улучшила то, что было и добавила нового. Но почему всё новое про контроль и отчётность? Вот и получается, что студентом я смог открыть интернет-магазин за 3 визита в разные места. А сейчас, чтобы продавать свистульки через интернет нужно пройти 7 кругов бюрократии, завести ассистента и несколько агентств. Что думаете про это?

Product Requirements Document — документ, призванный рассказать о сути продукта и его ключевых требованиях. Он здорово экономит время на первичное обсуждение идеи.

За последние несколько лет я посмотрел десятки примеров PRD. Документ из большой корпорации будет по строгому шаблону, в веб-студии — с акцентом на технологическую реализацию, а венчурному фонду будет интересен рынок и команда. Проще сделать документ под себя, чем подбирать подходящий.

Главная фишка PRD в том, что автор идеи сам отвечает на вопросы до того, как принесёт идею к партнёрам, инвесторам и участникам команды. Создание этого документа — фаза проработки идеи и глубокого осмысления своей задумки.

Не рекомендую делегировать составление этого документа на ИИ. Ваша главная задача — провести время за ответами, а не просто получить файл. Думаю, я бы не запустил некоторые свои проекты, если бы вначале уделил должное внимание документу с требованиями.

Мне нравится формат одностраничника — документ должен влезать на одну (две, три) распечатанную страницу. Более подробной спецификацией можно заниматься внутри производственных отделов на стадии реализации, а для верхнеуровневого обмена идеями хватит одного листа.

Скачать документ можно в следующем посте с розыгрышем.

Учёные изучили 17 языков, включая английский, итальянский, японский и вьетнамский с точки зрения скорости передачи информации. Сравнивали насколько сложно устроены языки: количество вариантов слогов и темп речи. И просили носителей рассказывать об одинаковых вещах на родном языке.

Выяснилось:

– Слоги в языках имеют разный “вес”: средний японский слог кодирует 5 бит, английский — 7 бит, а вьетнамский со сложной системой тонов — все 8 бит.

– В английском языке 6949 вариантов слога, в японском — 643. В 10 раз меньше, Карл!

– Чем выше плотность информации, тем медленнее речь. И наоборот.

– То есть, темп речи не влияет на информативность. Ученые измеряли как итальянцы тараторят на высокой скорости, а немцы говорят как будто замедленно. И все языки передают одинаковое количество данных в единицу времени.

– Язык — это кодек для информации. Если общение идёт с одной плотностью вне зависимости от алгоритма кодека, то ограничение находится не в самом языке.

– А значит нет более эффективного языка с точки зрения обмена информацией!

– Удалось посчитать и измерить скорость обмена данными между людьми — 39.15 бит в секунду. Телеграфное общение на азбуке Морзе в два раза медленнее. Домашний интернет на 100 мегабит в секунду — это 100 000 000 бит в секунду.

– Многие из нас ускоряют видео и аудиокниги. Мы можем слушать более быструю речь, чем говорим сами. Значит, кодирование потребляет больше ресурсов, чем декодирование.

– Реальный ограничитель не в программном обеспечении, а в аппаратном. На какой-то скорости мы уже не успеваем обдумывать услышанное, поэтому в плеерах максимальное ускорение 200%, а не 1000%.

От себя добавлю, что у компьютеров нет такого биологического ограничителя. Именно поэтому роботы общаются между собой на языке gibber, как R2D2 или AI-агенты в нашумевшем ролике.

Откройте на двух устройствах этот сайт и понаблюдайте за похожими диалогами между роботами.

Оригинальное исследование в журнале Science (на английском языке).

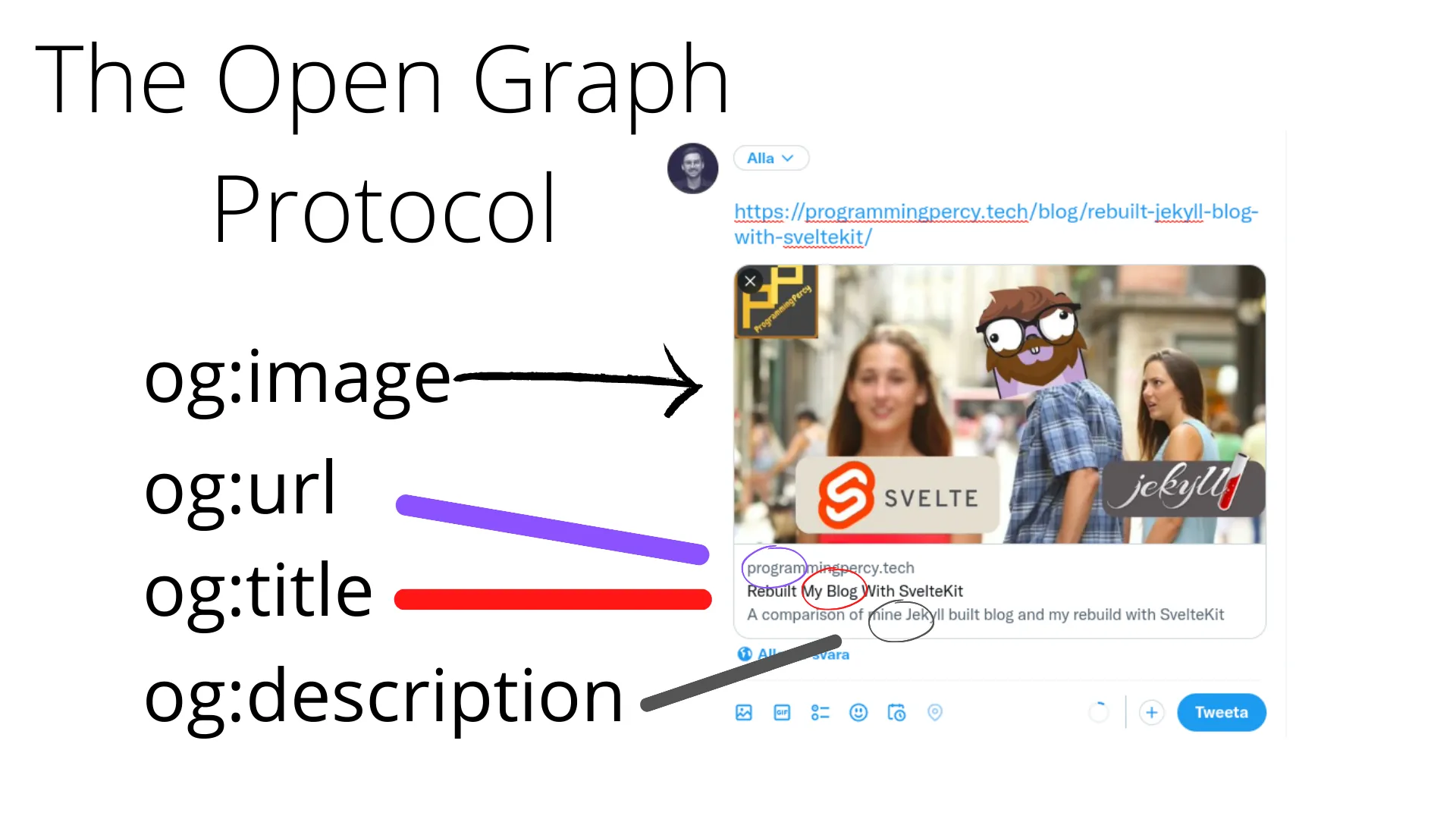

Пересылал в телеграме ссылку на свой блог fullstackfounder.ru и обратил внимание, что ссылка голая — в чате не отображается картинка и описание. Я хочу, чтобы ссылки были привлекательными, вдруг кто-то в чате поделится статьёй.

За эти улучшения отвечает протокол Open Graph. Чтобы он заработал, нужно добавлять в HTML-код страницы дополнительные поля, которые пользователь не увидит на сайте. Зато их прочитает робот социальной сети, когда кто-то перешлёт ссылку.

В WordPress из коробки Open Graph почему-то нет, поэтому ставлю плагин. Так сложилось, что в экосистеме WordPress за это отвечают сеошные плагины. Лидер — перегруженный старичок Yoast SEO. Но его я ставить не хочу — там слишком много невостребованных мной функций, он снижает производительность сайта и грубо вставляет куски своего интерфейса в админку.

Посмотрел альтернативы в каталоге плагинов — у Yoast не больше десяти конкурентов. Выбрал по описанию и поставил Slim SEO, минималистичный плагин с необходимыми мне возможностями:

Поставил и включил плагин. Протестировал как работает Open Graph в удобном онлайн-тестировщике. Всё заработало, ссылки стали полноценными! Попробуйте переслать эту статью.

Частая проблема — социальная сеть не обновляет ссылку, после того как мы поменяли картинку или текст. Нужно попросить соцсеть сбросить кэш.

Бот для сброса кэша в Telegram

Обнулятор от Callibri

Сброс кэша для LinkedIn

Телеграм — единственная социальная сеть, где я активен. Вот уже пятый месяц я пишу в канал каждый день. Меня много раз спрашивали, как это у меня получается? А я и сам не знал, что так могу!

Наташа из Галеры мне написала “пора канал завести”, я и завёл. А дальше что? Мне просто хотелось писать. Появилось желание сделать формулировки чётче и доносить мысли до окружающих яснее. Было понимание, что таким образом я смогу улучшить свою речь. Но писать регулярно содержательные материалы казалось нереальным.

Точно знаю, что мне помог челлендж Content Hero, к которому я присоединился как раз пять месяцев назад. Сейчас мы в небольшой группе принимаем участие в своеобразном литературном забеге. Каждый день нужно написать пост и публично отчитаться роботу, иначе штраф!

Что я узнал о себе по ходу челленджа:

В последнее время я стал замечать, что на консультациях пересказываю посты из канала. Есть и обратный эффект — после консультаций появляются идеи, о чём ещё написать в канал. Поэтому, если собираетесь ко мне на консультацию, есть смысл вначале перечитать всё опубликованное. Вдруг, я уже ответил на ваши вопросы?

Писать — это про путешествие внутрь себя, возможность отрефлексировать накопившийся опыт. Вместе с тем, канал стал средством и поводом для общения с новыми людьми, причиной приятных знакомств и коллабораций. Нужно было прийти к себе, чтобы выйти в люди.

Если хочется вести канал более ответственно — рекомендую присоединиться к Content Hero. Челендж не заканчивается, можно запрыгнуть в ближайший поток и попробовать писать каждый день.

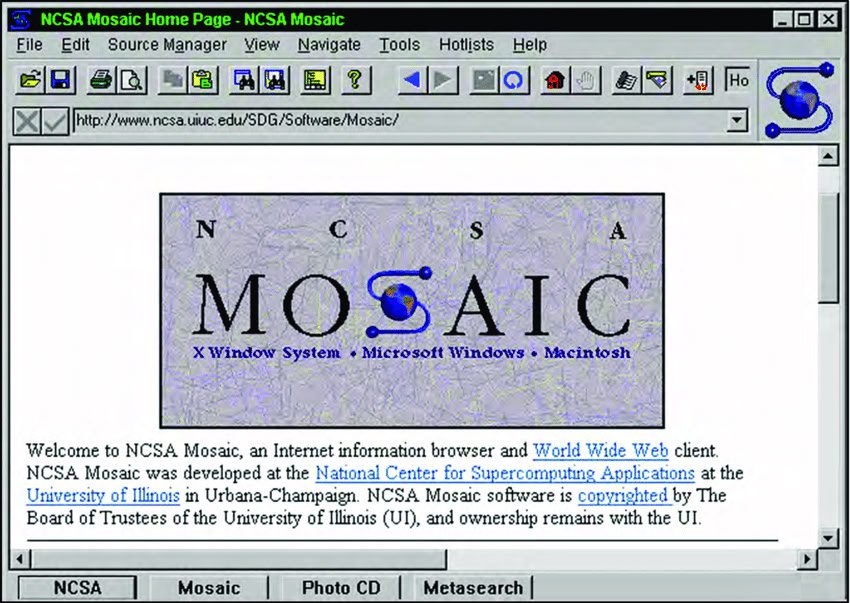

Mosaic — первый графический браузер, наследие которого мы видим во всех браузерах, которыми пользуемся сегодня.

В 1992 году в интернете было 26 сайтов, а браузеры были консольными и текстовыми. Национальный центр по разработке приложений для суперкомпьютеров при Университете Иллинойса получил государственный грант. В том же году его сотрудники Марк Андрисен и Эрик Бина начали разработку и в 1993 году выпустили браузер Mosaic.

Браузер совершил революцию и сделал интернет доступным для всех. После его выпуска, сайтами стало очень удобно пользоваться и их количество стало расти в геометрической прогрессии.

Некоторые фишки Мозайки:

– Графический интерфейс с кнопками и иконками, а не консольное приложение.

– Гипертекстовая навигация — переход по ссылкам по клику мыши.

– Картинки сразу отображались на веб-страницах. Раньше нужно было открывать их отдельно.

– Поддержка HTML-форм для отправки данных.

– Закладки в браузере.

– Поиск по странице.

Посмотри на скриншот интерфейса — за 30 лет интерфейс браузера не так сильно изменился.

Одна из его коммерческих версий была лицензирована компанией Microsoft и легла в основу нового браузера Internet Explorer.

Через несколько лет основные разработчики Mosaic основали компанию Netscape. Они написали с нуля код движка и разработали на его основе браузер Netscape Navigator.

Позже движок Netscape получил название Mozilla (Mosaic + Killer) и стал открытым. Сегодня на нём работает браузер Firefox.

Один из основных разработчиков Mosaic — Марк Андрисен, до сих пор не пропадает из новостей. Он является одним из основателей венчурного фонда a16z (Андрисен-Хоровиц). Фонд инвестировал в Facebook, Github, Airbnb, Figma, Oculus, Pinterest, Roblox, Coinbase, Skype, Slack и ещё в сотни компаний.

Как бы выглядел интернет сегодня, если бы первым стал не Mosaic?

Меня часто спрашивают: как понять, сколько брать за работу специалисту?

Предположим, что вы знаете, сколько часов занимает ваша работа. Если так, то я предлагаю рассчитать минимальную ставку за час. Показываю, как это сделать.

Производственный календарь говорит, что в 2025 году — 247 рабочих дней. В среднем 20,5 рабочих дня в месяце.

Стандартный рабочий день считается равным 8 часам. Но будем честны — есть ресурсоёмкая деятельность, а есть та, которую можно делать на автопилоте.

Посчитаем, что мы занимаемся сложной задачей, которая требует значительных умственных или физических усилий. Такой деятельностью можно заниматься продуктивно 6 часов в день.

6 часов × 20,5 рабочих дней = 123 рабочих часа в месяц.

Предположим, что наш специалист хочет получать 150 тысяч рублей в месяц. Значит, его час должен стоить 150 000 / 123 = 1220 рублей.

Если ему удаётся продать все 123 часа оптом в одни руки, да ещё и с гарантией выкупа, то это и есть цена продажи.

У фрилансера или консультанта продаются не все часы, поэтому нужно сделать наценку. Не продаётся 20%, значит каждый проданный час должен стоить на 20% дороже. 1220 рублей × 120% = 1464 рубля.

В первую очередь, стремимся продать весь инвентарь часов, чтобы получить стабильность. А уже после повышаем ставку или выбираем более выгодные проекты. Такой подход защищает от проседания по загрузке и позволяет поднимать цену без внутреннего сопротивления.

Мы получили 647 посетителей, 105 лидов и 17 продаж.

Как понять, можно ли доверять полученным конверсиям из посетителя в лида и из лида в продажу? Не рано ли делать прогнозы или уже можно принимать судьбоносные решения?

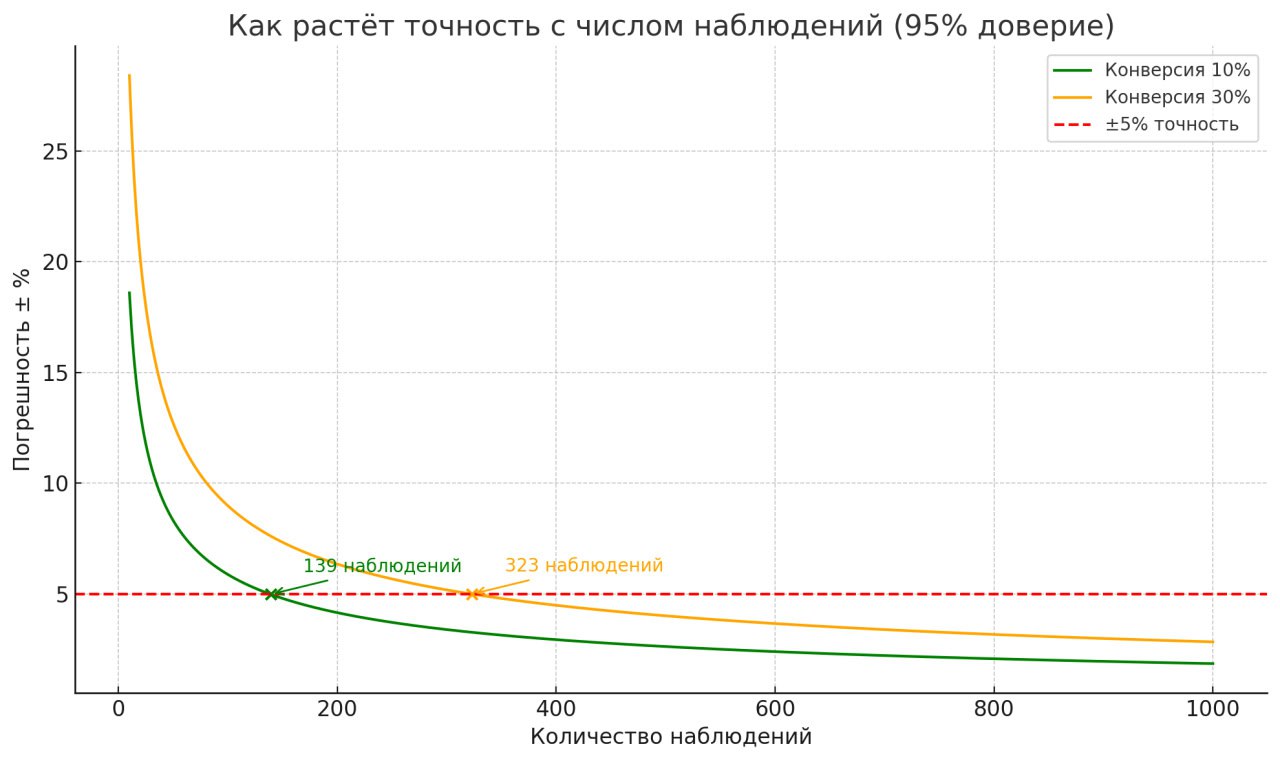

Применяем математику на практике — вычисляем погрешность. Нам нужно, чтобы погрешность была менее +/-5 процентных пунктов.

Наши переменные:

– Объём выборки 647 посетителей.

– Текущее значение конверсии, 105 лидов / 647 посетителей * 100% = 16.2%.

– Вероятность ошибки — каков шанс, что мы ошибаемся? Классический уровень для первого расчёта — 5%. Если нужна повышенная увереность при работе с важными данными, можно поставить вероятность ошибки 1%.

Спрашиваем GPT: Рассчитай точность определения конверсии для 105 лидов на 647 посетелей при вероятности ошибки 5%

Получаем ответ: Погрешность +/-2.8 п.п..

Т.е. реальная конверсия может лежать в пределах от 13.4% до 19.0%. С такой точностью можно строить прогнозы и принимать решения.

Если рассчитать погрешность для продаж из начала поста, то получится погрешность +/-10 п.п. Широкий интервал, но границы диапазона уже можно увидеть. Нужно добрать лидов, чтобы сузить интервал и сделать более точные выводы.

Простой лайфхак:

В начале сбора данных точность очень быстро растёт, а потом рост точности замедляется. Посмотрите на график: в зависимости от конверсии, точность 95% мы получим на выборке от 139 до 323 случаев.

Можно использовать это как ориентир:

– после 300 посетилей можно заниматься оптимизацией посадочной.

– после 300 лидов — садиться переписывать скрипты.

Так что, 300 раз отмерь, один отрежь. И да простят меня математики.

При столкновении с неизвестной проблемой, мы решаем её привычным способом, даже если он не подходит к ситуации. Мы склонны игнорировать лучшие решения, если раньше с ними не сталкивались.

Это когнитивное искажение, известное как эффект Эйнштеллунга. Наш опыт блокирует гибкость мышления. Это происходит из-за стремления мозга не напрягаться. Он ленится придумывать и рассматривать новые варианты.

Ярче всего этот эффект проявляется у шахматистов — они предпочитают разыгрывать знакомую стратегию, даже если есть другое решение с меньшим количеством ходов.

У врачей принято просить второе мнение, чтобы снизить вероятность ошибки. То же самое полезно делать и в других ситуациях, можно советоваться с уважаемыми коллегами из разных областей.

В чем вызов: осознать, что попадаешь под действие этого эффекта. Не применять поспешные решения, основанные на своём прошлом опыте. Ставить прошлый опыт под сомнение, задавать провокационные вопросы, включать “мышление новичка”, искать свои слепые зоны. Особенно, если сразу знаешь, как решать возникшую проблему.